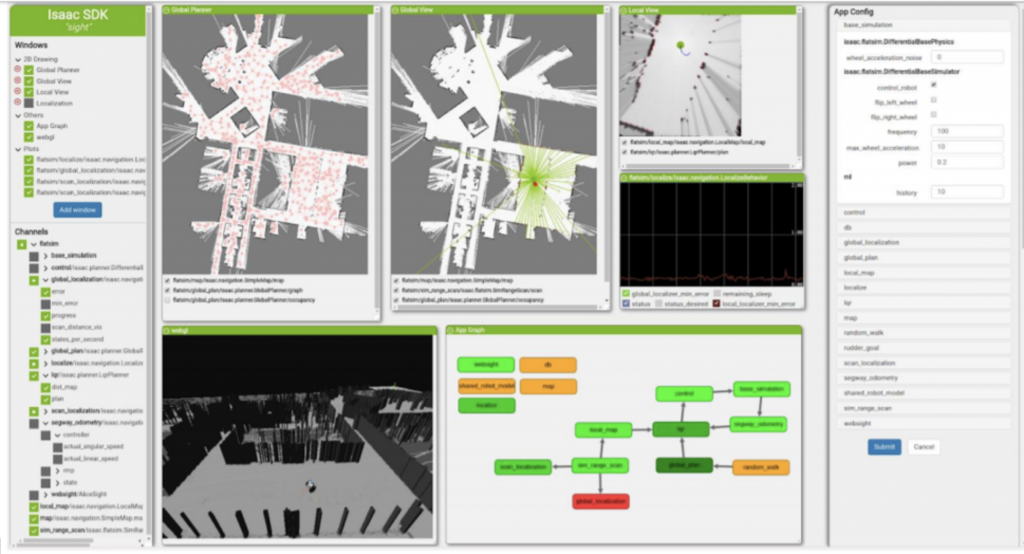

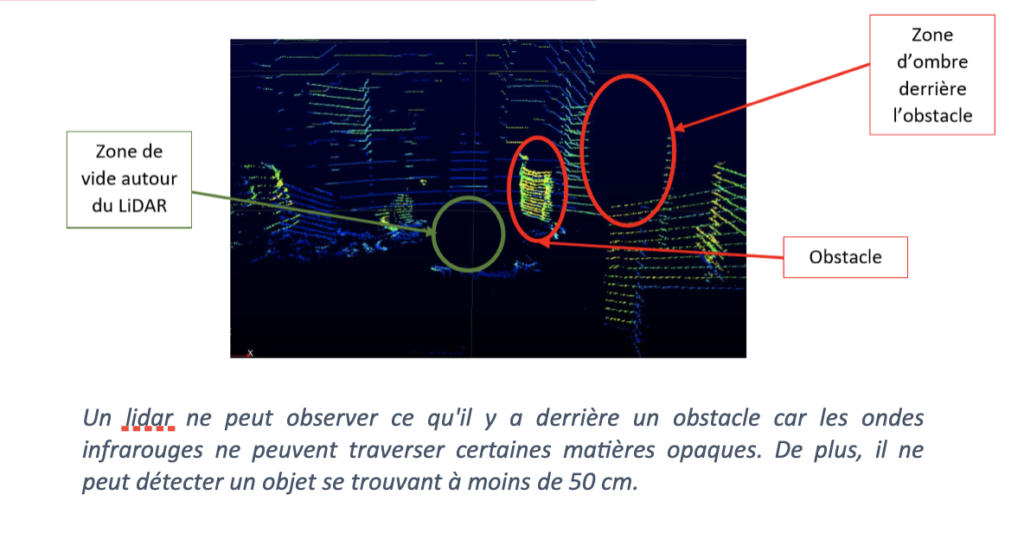

Le capteur LiDAR (Détection de la lumière et mesure à distance), qui permet de reconstituer des environnements en trois dimensions, est un élément majeur des véhicules autonomes. Pour atteindre une grande autonomie, le véhicule a besoin d’être renseigné sur l’environnement qui l’entoure. C’est pourquoi différents capteurs sont mis en place : caméra, sonar, radar mais aussi LiDAR. Celui-ci fonctionne grâce à une technique optique active de mesure à distance. Il émet une onde lumineuse grâce à un laser qui se réfléchit sur un objet et est ensuite détectée par le télescope à l’intérieur du LiDAR. Par la suite, un photo-détecteur convertit cette lumière en signal électrique qui est envoyé à un système de traitement. Le temps pris par une impulsion laser pour parcourir l’aller-retour entre le lidar et une cible est mesuré ce qui permet de déduire la distance entre l’objet et le LiDAR en connaissant la vitesse de propagation de l’onde. La vitesse de l’objet est calculée grâce à la variation de fréquence entre l’onde émettrice et l’onde réceptrice (effet Doppler).

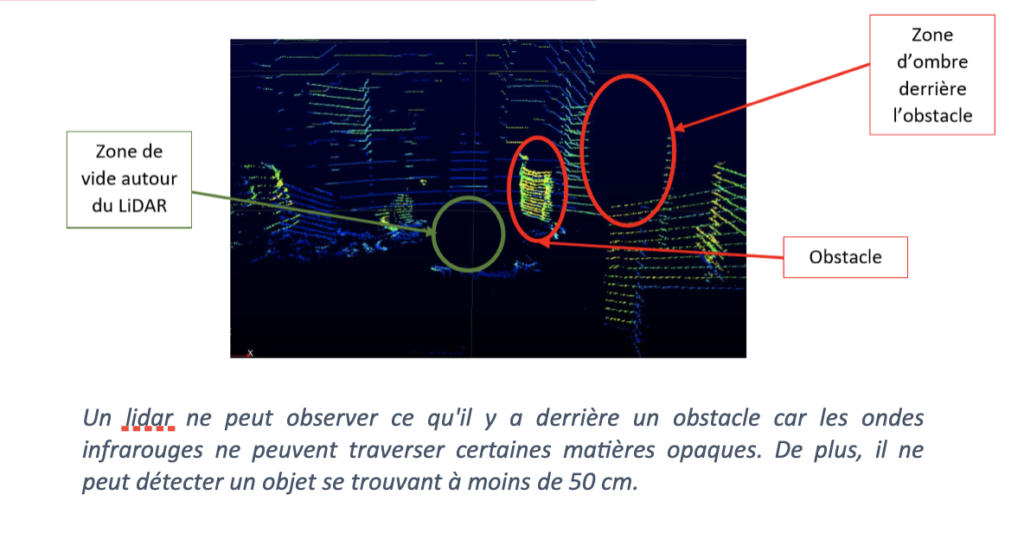

Le LiDAR se distingue des autres capteurs par une très grande précision dans la mesure de distance due à de courtes impulsions. De plus, il permet de cartographier un environnement 3D en temps réel grâce à sa rapidité de traitement et d’acquisition des données. Cependant, certains matériaux (verre, métaux polis) peuvent ne pas être détectés. L’objectif du projet a été de déterminer les différentes conditions qui peuvent poser problème au LiDAR. Ensuite, plusieurs mesures avec le LiDAR sous différentes conditions ont été effectuées et analysées pour vérifier si elles étaient en accord avec les hypothèses. Puis, on a déterminé dans quelles situations réelles ces conditions pouvaient poser problème.

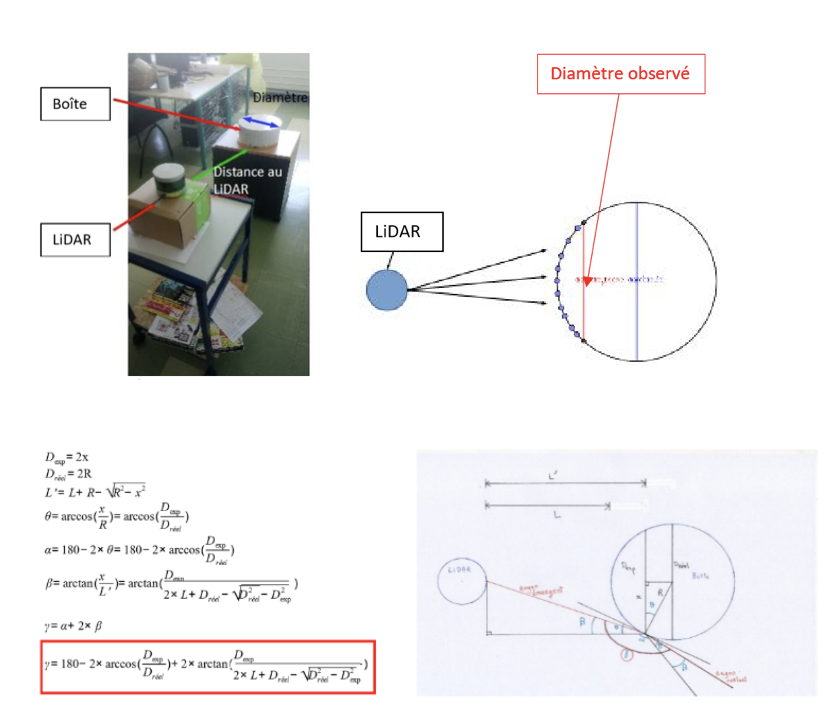

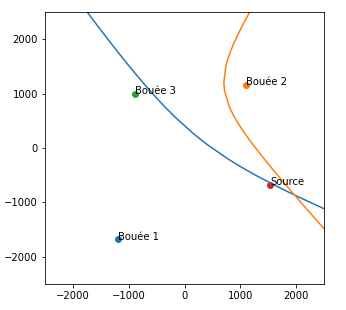

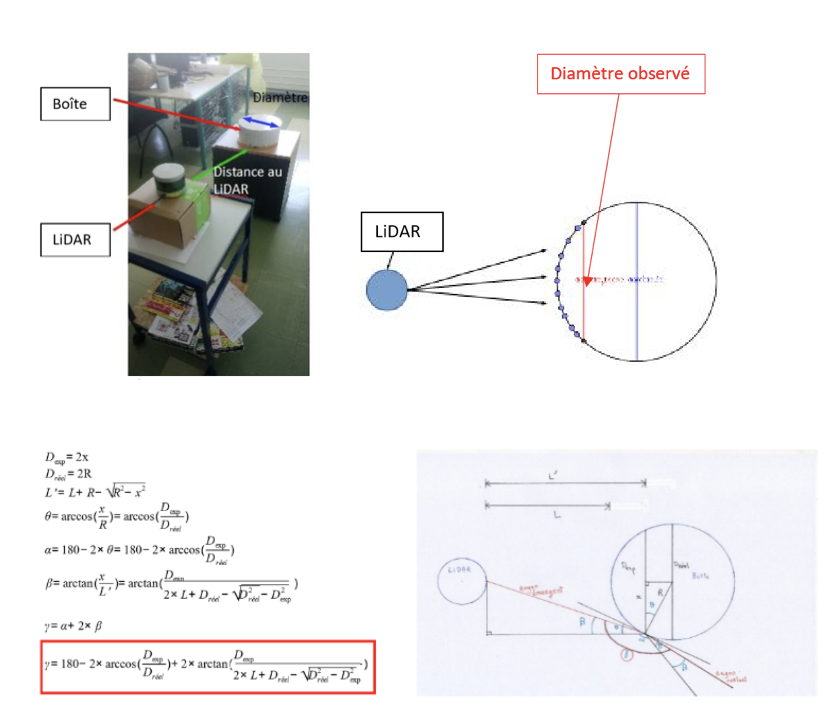

Les différentes expériences ont montré qu’un objet cylindrique n’était pas totalement détecté par le LiDAR. On observe donc un diamètre sur l’image qui est plus petit que le diamètre réel. Pour estimer, ce problème, on calcule par exemple la valeur de l’angle limite de déviation